Paternalismo en el algoritmo

AI Empatía Sintética Ética

No hay día en el que no estemos rodeados de algoritmos que intentan orientar nuestras elecciones. Lo vemos, por ejemplo, en las redes sociales con sistemas que se alimentan de nuestra interacción, a veces casi imperceptible, y ajustan lo que se nos muestra para inclinar la balanza hacia ciertos contenidos. En ese contexto, nuestras decisiones dejan de ser completamente nuestras, porque se toman dentro de un entorno diseñado para empujarnos en una dirección.

A menudo asumimos que esta delegación se hace “por nuestro bien”, para ahorrarnos tiempo y evitar la carga mental de decidir qué ver en una de nuestras pocas noches de descanso. Y, superficialmente, funciona. Una ayuda ante la indecisión suele percibirse como algo positivo. Pero la cuestión cambia cuando el algoritmo decide de forma unilateral, a partir de información parcial, sesgada, incompleta o condicionada, y además, lo hace sin que el usuario sea plenamente consciente de cómo se ha llegado a esa recomendación.

El paternalismo algorítmico puede entenderse como la intervención de sistemas computacionales o de inteligencia artificial en la toma de decisiones humanas, guiando o limitando la libertad de elección hacia resultados que el sistema, o quienes lo diseñan, consideran “mejores”. El rasgo crítico es que esta orientación puede operar de forma opaca, de modo que la persona no siempre percibe cuánto de su decisión proviene realmente de su deliberación y cuánto del diseño del entorno.

Me sorprendió que los algoritmos fueran presentados y comercializados como un hecho objetivo. Una descripción mucho más precisa de un algoritmo es que es una opinión incrustada en matemáticas.

Y si esa opinión además no podemos verla por dentro, entonces el problema ya no es solo qué decide el sistema, sino cómo y para quién lo está decidiendo.

Actualmente, el paternalismo algorítmico no suele considerarse entre los riesgos más visibles asociados a los avances informáticos. Sin embargo, a medida que se generalizan modelos de tipo caja negra (black box) y disminuye la explicabilidad, se vuelve más difícil auditar por qué el sistema recomienda, prioriza o descarta ciertas opciones. En ese escenario, no podemos asumir que la delegación de decisiones vaya a operar siempre en beneficio del usuario. También puede reflejar sesgos del dato, incentivos comerciales o criterios de diseño que no coinciden con nuestros valores, gustos o preferencias.

La justificación que se nos ha entregado ante la necesidad de este fenómeno se apoya, en gran medida, en una idea previa, que las personas somos seres irracionales y que, por tanto, necesitamos “ayuda” para decidir mejor. En esta línea, Dan Ariely populariza la tesis de que somos “seres sistemática y predeciblemente irracionales” en su libro Predictably Irrational: The Hidden Forces That Shape Our Decisions. Ariely sugiere que esa irracionalidad aparece como una distancia recurrente entre la manera en la que nos gustaría comportarnos y la forma en la que realmente lo hacemos, una brecha persistente que él denomina The Potential Human Gap.

Pero no todo el mundo compra esa premisa de partida. En contraposición, Herbert Simon matizó que el ser humano sí puede ser racional, aunque bajo límites muy concretos como el tiempo, información disponible, capacidad de cálculo, contexto… Es decir, no es tanto irracionalidad como racionalidad limitada, decidimos lo mejor posible con lo que tenemos, no con lo que sería ideal tener.

A pesar de esta matización, la idea de que somos seres irracionales ha ganado siempre esta batalla, minusvalorándonos como seres capaces de tomar decisiones y justificando así la idea de que la tecnología, los algoritmos y la IA serán más aptos para tomar decisiones que nosotros mismos. Además, con la idea de que esta irracionalidad es incorregible, se invita al aprovechamiento de estas deficiencias en nuestras capacidades para reconducir nuestro comportamiento, ya no solo corregirlo, sino dirigirlo de forma intencional.

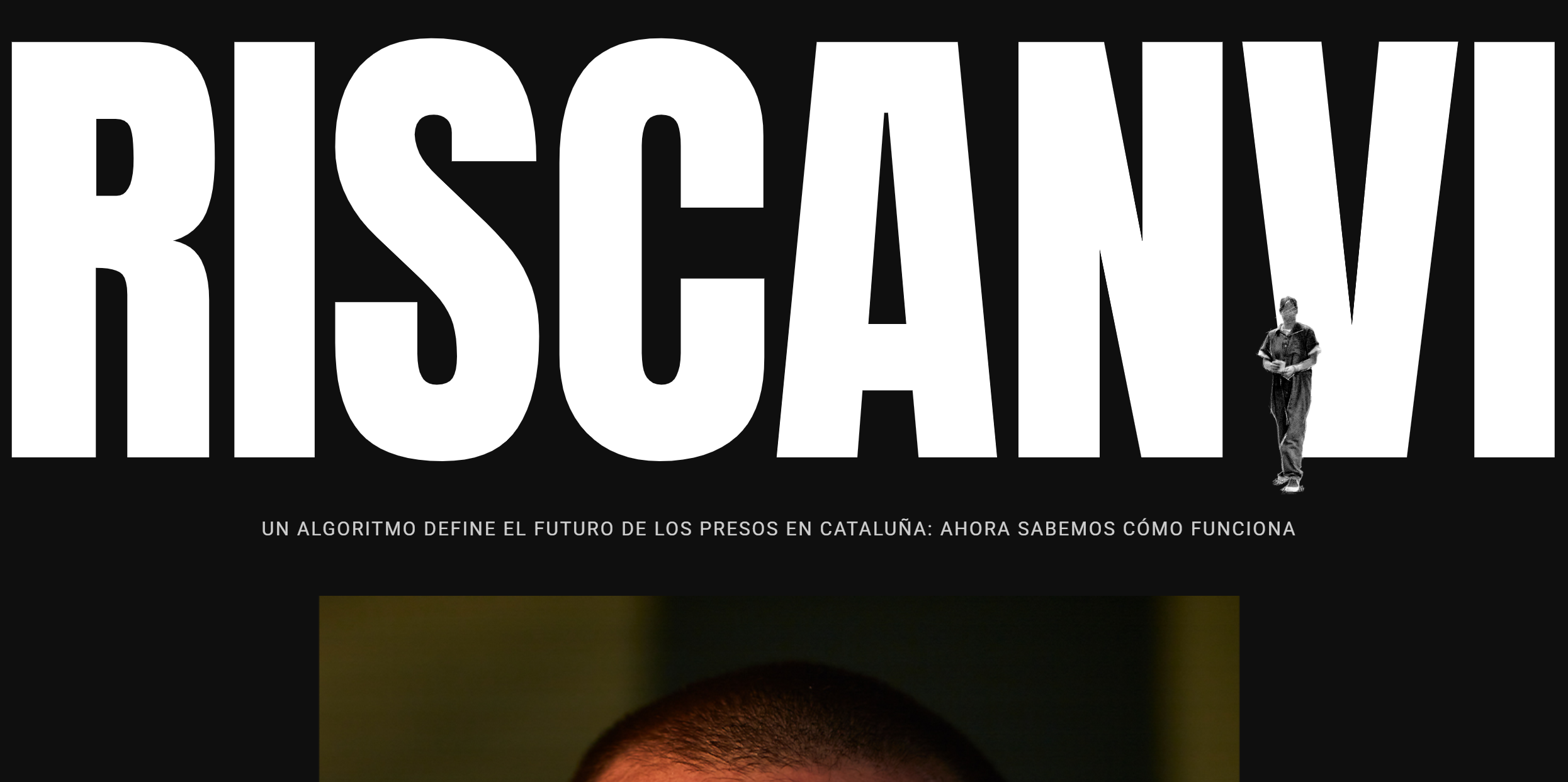

Un ejemplo claro en Cataluña es RisCanvi, una herramienta institucional para valorar el riesgo (incluida la reincidencia) en el ámbito penitenciario. El problema ético aparece cuando esa valoración técnica funciona como paternalismo algorítmico, el sistema etiqueta a la persona como más o menos peligrosa y esa etiqueta condiciona decisiones sensibles como la intervención, clasificación, permisos... desplazando la deliberación humana hacia una lógica probabilística. Si además el modelo es opaco o difícil de impugnar, se debilitan la autonomía, la explicabilidad y la justicia ante errores o sesgos, reduciendo a la persona a un perfil de riesgo difícil de contradecir cuando no hay explicación comprensible.

En última instancia, el problema no es que existan sistemas que ayuden a decidir, sino que la ayuda se transforme en dirección sin consentimiento plenamente informado. Cuando aceptamos que un modelo, por eficiente que sea, puede sustituir nuestra deliberación, estamos cediendo algo más que tiempo. Cedemos el criterio sobre lo que cuenta como una buena decisión. Y ahí el paternalismo algorítmico deja de ser una comodidad tecnológica para convertirse en una cuestión moral y política: quién define lo mejor, con qué fines, y bajo qué condiciones de transparencia y rendición de cuentas. Si no podemos ver, comprender y cuestionar la lógica que nos empuja, entonces la delegación ya no es asistencia, es gobierno sobre nuestras elecciones.